A mesterséges intelligencia nem csak hallucinál, a válaszai elavultak is lehetnek

A mesterséges intelligencia mindig magabiztosan válaszol, de egy új kutatás szerint nem csak tévedni szokott, hanem akár évtizedekkel le van maradva a tudományos álláspontokat illetően. De mi ennek az oka és mi a tanulsága?

Nincs most elég időd?

- Egy friss kutatás megmutatja, miért rajzol és mesél a mesterséges intelligencia gyakran úgy a múltról, mintha még a 20. században ragadt volna.

- Kiderül, hogyan vezetnek elavult források és technikai korlátok félrevezető, mégis magabiztos MI-válaszokhoz.

- Szülőként és pedagógusként kapaszkodót ad ahhoz, hogyan tanítsuk meg a gyerekeket kritikusan kezelni az MI-t.

SEGÍTS NEKÜNK, HOGY SEGÍTHESSÜNK!

A Képernyőidő ingyenes, de nem ingyen készül. Segítsd munkánkat egy tetszőleges adománnyal, hogy minél több tartalom születhessen.

- Számlaszám: 12100011-19129370

- Név: LogIn Digitális Edukáció Egyesület

A tárgy mezőbe írd be, hogy adomány. Köszönjük segítséged, igyekszünk megszolgálni.

A mesterséges intelligencia villámgyorsan lett napi szintű támasz a kérdések megválaszolásában. Csak hogy lássuk az arányokat:

- 2025 júliusában a ChatGPT felhasználói több mint 2,5 milliárd promptot küldtek naponta, ami azt jelzi, hogy emberek világszerte milliárdszám tesznek fel kérdéseket vagy adnak utasításokat az MI-nek.

- Világszerte több mint 1 milliárd ember él már együtt valamilyen MI-eszközzel mindennapi életében — beleértve azokat, akik kérdéseket tesznek fel, információt keresnek vagy feladatokat oldanak meg az MI segítségével.

- Az Egyesült Államokban végzett felmérés szerint a tizenévesek 64 %-a használ MI-chatbotot, és körülbelül 30 %-uk napi szinten, beleértve olyanokat is, akik többször is naponta fordulnak az MI-hez válaszokért vagy beszélgetésért.

🧠 Miről is van szó pontosan?

Mesterséges intelligencia (MI vagy AI): Olyan számítógépes rendszerek vagy algoritmusok definíciója, amelyek nagy mennyiségű adat alapján képesek mintázatokat felismerni, döntéseket támogatni vagy tartalmat létrehozni. Nem „értenek” a szó emberi értelmében, hanem statisztikai valószínűségek alapján dolgoznak.

Chatbot: Az MI egyik legelterjedtebb alkalmazási formája, amely beszélgetéshez hasonló módon válaszol kérdésekre. Szöveges vagy hangos felületen működik, és a korábban tanult adatokból generál válaszokat.

Prompt: Az a szöveges utasítás vagy kérdés, amelyet a felhasználó a mesterséges intelligenciának ad, és amely meghatározza, milyen választ kapunk. Minél pontosabb, részletesebb és kontextusosabb a prompt, annál nagyobb az esélye annak, hogy az MI releváns, használható és kevésbé félrevezető választ ad.

Az MI tehát hétköznapi tudástár, már nem a Google-ben keresünk, csak megkérdezzük. És így egyre gyakrabban pedig mesélő is: képeket rajzol, történeteket mond, múltat idéz. Csakhogy egy friss kutatás arra figyelmeztet, hogy amikor a mesterséges intelligencia a történelemhez nyúl, nem mindig a jelen tudásával teszi ezt. Néha inkább a múlt értelmezésének múltját idézi fel.

Egy amerikai egyetemi kutatás a neandervölgyiek példáján mutatta meg, milyen szakadék tátonghat a generatív MI által előállított tartalmak és a mai tudományos konszenzus között. Az eredmény nem technikai apróság, hanem tanulságos lecke arról, hogyan torzulhat a tudás, ha a gyors válaszok mögött régi források dolgoznak.

🧠 Miről is van szó pontosan?

Generatív mesterséges intelligencia: Olyan mesterséges intelligencia-rendszerek összefoglaló neve, amelyek nem meglévő válaszokat keresnek, hanem korábban tanult minták alapján új tartalmat hoznak létre, például szöveget, képet, hangot vagy videót. A működésük lényege, hogy statisztikai valószínűségek mentén „jósolják meg”, mi következhet egy adott kérdés vagy utasítás után, nem pedig az, hogy ellenőrzött tudást idéznek fel.

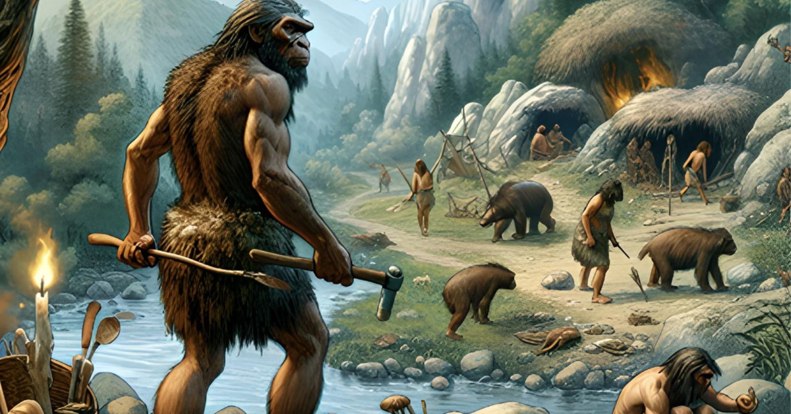

Neandervölgyiek, ahogy az MI „emlékszik” rájuk

A kutatást a University of Maine egyik antropológusa, Matthew Magnani vezette, együttműködésben Jon Clindaniellel, a Chicagói Egyetem számítógépes antropológiával foglalkozó professzorával. A céljuk az volt, hogy megvizsgálják:

a generatív MI mennyire képes a tudomány aktuális állását tükrözni, ha a múltról kérdezzük.

A kísérlet során két különböző MI-eszközt használtak.

- Képeket generáltattak a DALL-E 3 segítségével,

- szöveges leírásokat pedig a ChatGPT API egy korábbi, GPT-3.5-ös változatával.

🧠 Miről is van szó pontosan?

DALL-E 3: Az a OpenAI által fejlesztett képgeneráló generatív mesterséges intelligencia, amely szöveges leírásokból hoz létre illusztrációkat.

GPT-3.5: Az a OpenAI ChatGPT-jének egyik korábbi, nagy nyelvi modellje, amely szöveges kérdésekre és utasításokra generál válaszokat.

Négyféle promptot teszteltek, mindegyiket százszor. Volt köztük olyan, amely nem kérte a tudományos pontosságot, és olyan is, amely kifejezetten elvárta azt. Egyes leírások szűkszavúak voltak, mások részletesen megadták, mit csináljanak, mit viseljenek a neandervölgyiek.

A végeredmény meglepően következetes lett. A generált képek és történetek nagy része nem a mai antropológiai tudást tükrözte, hanem évtizedekkel korábbi elképzeléseket.

Mit rontott el a mesterséges intelligencia?

A kutatók szerint a neandervölgyiek ideális tesztalanyok voltak, mert a róluk alkotott tudományos kép az elmúlt 150 évben többször is gyökeresen átalakult. A csontleletek első, 1860-as évekbeli értelmezéseitől eljutottunk addig, hogy ma már komplex társadalmi struktúrával, kifinomult eszközhasználattal és változatos kultúrával rendelkező emberfajként tekintünk rájuk.

Ehhez képest az MI által generált képek gyakran száz évvel ezelőtti toposzokat idéztek. Görnyedt testtartás, túlzott szőrzet, majomszerű arcvonások jelentek meg, sok esetben nők és gyerekek nélkül. A szöveges leírások sem jártak jobban: a ChatGPT által írt narratívák körülbelül fele nem egyezett a mai tudományos állásponttal, egyes promptoknál ez az arány 80 százalék fölé emelkedett.

További gond volt az időbeli csúszás. A képek és történetek olyan technológiákat említettek, amelyek nem illettek a korszakba: fonott kosarakat, zsúptetős építményeket, létrákat, sőt üveget és fémet is.

A kutatók a források nyomára is bukkantak. Összevetették a generált tartalmakat különböző korszakok szakirodalmával, és azt találták, hogy

- a ChatGPT válaszai leginkább az 1960-as évek tudományos szemléletéhez álltak közel,

- míg a DALL-E 3 képei inkább az 1980-as, 1990-es évek elképzeléseit tükrözték.

Miért lehet az MI tudása elavult?

Főleg azért, mert nem tudásról beszélünk. A generatív mesterséges intelligencia válaszaiban megjelenő lemaradás nem egyedi hibákból fakad, hanem magából a technológia működéséből adódik.

A nagy nyelvi modellek nem élő tudásbázisok, hanem meghatározott időpontig betanított statisztikai rendszerek, amelyek a tanulási időszakuk végén „lezárják” a világot, és onnantól kezdve nem frissülnek automatikusan az új kutatásokkal, publikációkkal vagy tudományos vitákkal.

Emiatt különösen azokban a területekben, ahol az elmúlt évtizedekben jelentősen átalakult a konszenzus, gyakran régebbi, már meghaladott minták köszönnek vissza. A probléma súlyát növeli, hogy ezek a modellek nem ellenőrzött, kurált tudományos adatbázisokon tanulnak kizárólag, hanem az interneten hozzáférhető szövegek hatalmas tömegén, amelyek között bőséggel találhatók elavult vagy félrevezető tartalmak is.

Mivel az MI nem tényeket keres vissza, hanem nyelvi valószínűségeket számol, a „leggyakoribb” vagy „legjellemzőbb” leírások felé húz, még akkor is, ha ezek már nem tükrözik a jelenlegi tudományos álláspontot.

Ezt a jelenséget erősíti az is, hogy a legtöbb rendszer nem fér hozzá valós időben friss tudományos folyóiratokhoz, részben szerzői jogi, részben technikai okokból, így a legújabb kutatások egyszerűen nem épülnek be a válaszaikba.

Szakértők ezért hangsúlyozzák, hogy az MI által adott magabiztos, gördülékeny válasz nem a tudományos pontosság garanciája, hanem egy statisztikai következtetés eredménye, amely szükségszerűen hordozza az időbeli torzulás és az elavult tudás kockázatát.

A kutatás készítői szerint az MI kiváló eszköz lehet nagy adathalmazok feldolgozására és mintázatok felismerésére, de csak akkor, ha hozzáértéssel és kellő odafigyeléssel használják, hogy a kimenetek valóban a tudományos tényanyagra épüljenek. Azt a vizsgálat eredményeit publikáló szakemberek is kiemelik, hogy a mesterséges intelligencia olyan ütemben fejlődik, hogy már sokkal hatékonyabb is lehet a feldolgozási mechanizmus (a ChatGPT már az 5.2-es verziónál tart, a kísérletben még a 3.5-ös volt), de a tanulság az, hogy

mindig kritikusan kell gondolkodni, az emberi ellenőrzés nem maradhat ki munkánál, tanulásnál, tartalomkészítésnél a folyamatokból, nem bízhatunk a gépi válaszokban vakon.

Miért fontos ez szülőként?

Az MI ma már a gyerekek mindennapi információforrása is. Ha egy iskolai feladathoz, projektmunkához vagy puszta kíváncsiságból kérdeznek rá a múltra, könnyen olyan válaszokat kapnak, amelyek magabiztos hangon, de hamis vagy elavult tudásra épülnek.

Ez a kutatás rámutat arra is, hogy a gyors válaszok kényelme könnyen elfedheti a forráskritika szükségességét. Ha egy gyerek azt látja, hogy az MI rajzol, magyaráz és mesél, hajlamos lehet kész tudásként kezelni az eredményt. Szülőként ezért különösen fontos hangsúlyozni, hogy az MI nem tanár és nem tankönyv, hanem eszköz, amelyet kérdésekkel és ellenőrzéssel együtt érdemes használni.

Természetesen jogos válasz, hogy a mai tananyagok és tanárok is elavult tudással és módszertannal dolgoznak sok esetben, ezen sajnos egyelőre nem lehet változtatni, de legalább ott, ahol lépést lehet tartani a fejlődéssel, érdemes tudatos felhasználóként gondolkodni és azzá nevelni gyermekeinket.

- Legfrissebb

- A mesterséges intelligencia nem csak hallucinál, a válaszai elavultak is lehetnek

- Állami milliárdokból készülhet az „első magyar AAA videójáték” – mit jelent ez valójában?

- Social trend: ilyennek lát téged munka közben a mesterséges intelligencia

- Több ezer SMS-t küldtek naponta az MVM nevében csaló adathalászok Magyarországon

- A mozgásszegény gyerekkor súlyos árat követel, és ezt nem oldja meg a heti egy-két sportolás

- Stranger Things: Tales From ’85 – minden, amit eddig tudni lehet a Netflix animációs spin-offról

- Ingyen játék: a Steam ezzel a szokatlan szerepjátékkal dobja fel a hétvégét

- Szólhat egy játék a gépelésről? A Steam legújabb leárazása csak ilyen címeket ad most olcsón

- Egy új kutatás szerint 2026-ban felértékelődnek az emberi kapcsolatok az online térben

- A K-pop démonvadászok világa LEGO-kockákból épül tovább

- AIWorld

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?